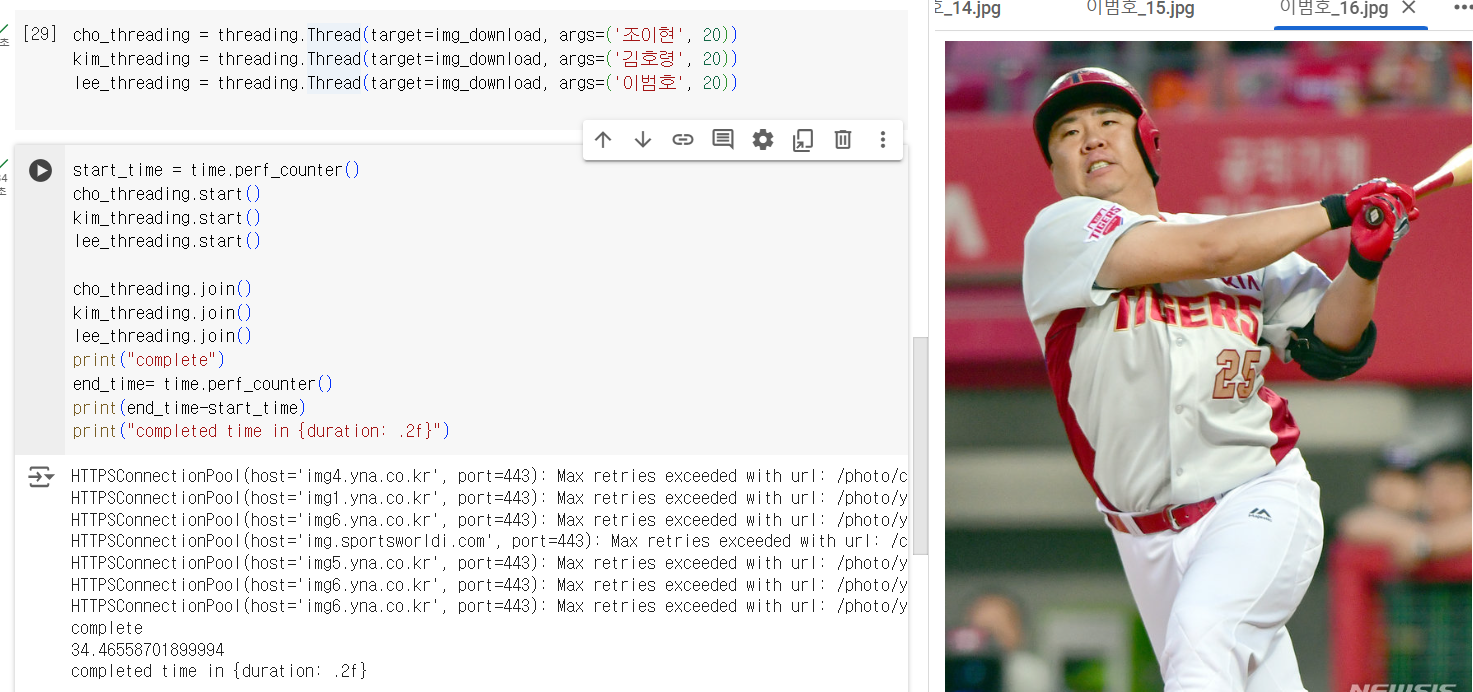

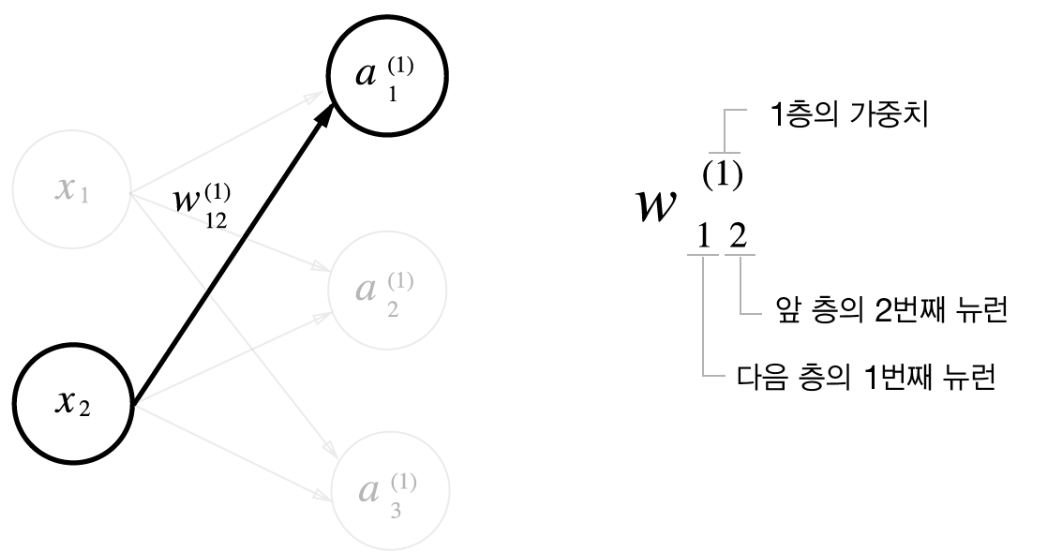

오늘 학습 내용 소개!!전이 학습 (Transfer Learning):전이 학습은 기존에 학습된 모델의 지식을 활용하여 새로운 작업에 적용하는 기법입니다.예를 들어, VGG16과 같은 사전 훈련된 모델을 사용하여 초기 가중치를 가져오고, 그 다음 새로운 데이터셋에 맞게 모델을 미세 조정(fine-tuning)할 수 있습니다.이미지 데이터 전처리 및 증감 (Data Preprocessing & Augmentation):이미지 데이터를 사용하기 전에 전처리 과정이 필요합니다. 이는 이미지 크기 조정, 정규화, 밝기 조절 등을 포함합니다.증감은 데이터셋을 더 다양하게 만들기 위해 이미지를 변형하는 기법입니다. 회전, 반전, 확대/축소 등이 있습니다.웹에서 이미지를 다운로드하고 스레딩을 사용하여 효율적으로 처리..